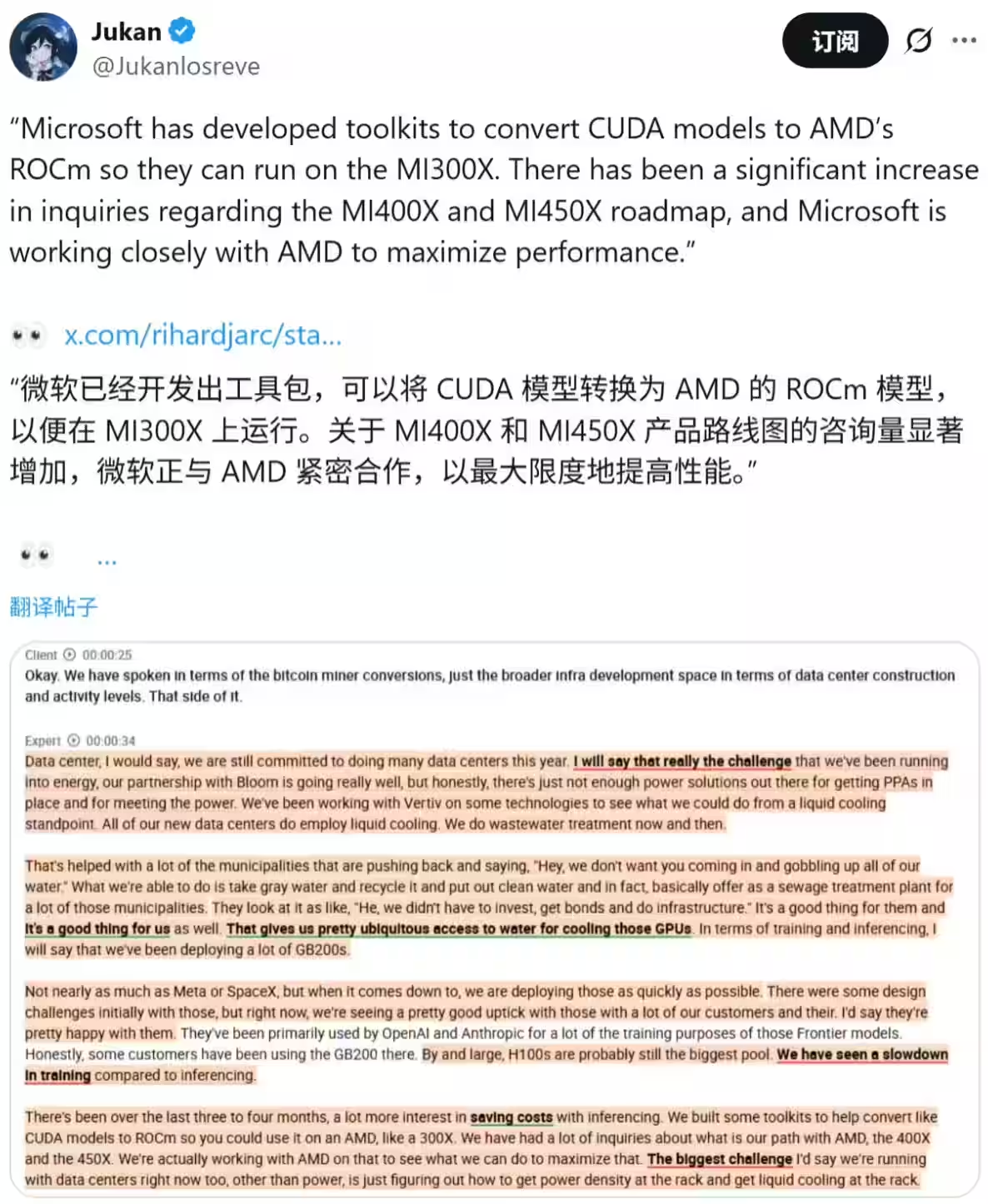

11 月 10 日消息,科技媒体 Wccftech 发布博文,报道称微软为打破英伟达 CUDA 在 AI 领域的软件生态霸权,已开发出一套专用“工具包”,核心功能是将为英伟达 GPU 编写的 CUDA 模型代码,自动转换为兼容 AMD ROCm 平台的版本。

援引博文介绍,一位微软高管透露,公司已成功开发出专用“工具包”(尚未透露具体名称),能够将基于英伟达 CUDA 编写的 AI 模型代码,翻译成 AMD ROCm 平台支持的版本。

这意味着原本锁定在英伟达硬件生态中的 AI 应用,未来或可在 AMD 的 AI GPU(如 MI300X 系列)上无缝运行。此举被视为微软打破英伟达 CUDA 软件护城河、推动 AI 硬件多样化的重要战略布局。

英伟达之所以能在 AI 领域保持绝对优势,其强大而成熟的 CUDA 软件生态是关键。CUDA 已成为 AI 行业事实上的标准,被开发者广泛采用,其竞争对手 AMD 的 ROCm 平台在生态成熟度和市场占有率上仍有较大差距。

要打破这种近乎垄断的局面绝非易事。微软此次开发的工具包,正是试图通过技术手段绕开生态壁垒,为市场提供一个“平替”方案,降低开发者迁移平台的门槛。

该媒体报道分析,微软的工具包很可能采用了一种名为“Runtime 兼容层”的技术。该技术无需对 AI 模型的源代码进行大规模重写,而是在程序运行时实时拦截 CUDA 的 API(应用程序编程接口)调用,并将其动态翻译成 ROCm 能够理解的指令。

开源项目 ZLUDA 就是此类技术的实例,通过这种方式,可以显著降低迁移成本和技术风险,但其有效性高度依赖于翻译的精准度和完整性。

该媒体指出,微软之所以投入资源开发此类转换工具,其根本原因在于 AI 推理需求的急剧增长。相比于一次性的模型训练,模型的日常推理应用产生了持续且庞大的算力需求。

英伟达 GPU 虽然性能强大,但价格昂贵,导致推理成本居高不下。因此,微软急于寻找更具成本效益的硬件方案,而 AMD 的 AI 芯片正是理想的替代者。通过实现 CUDA 到 ROCm 的转换,微软旨在为客户提供更灵活、更经济的 AI 算力选择。

coNoc1 年前

可乐辅助网